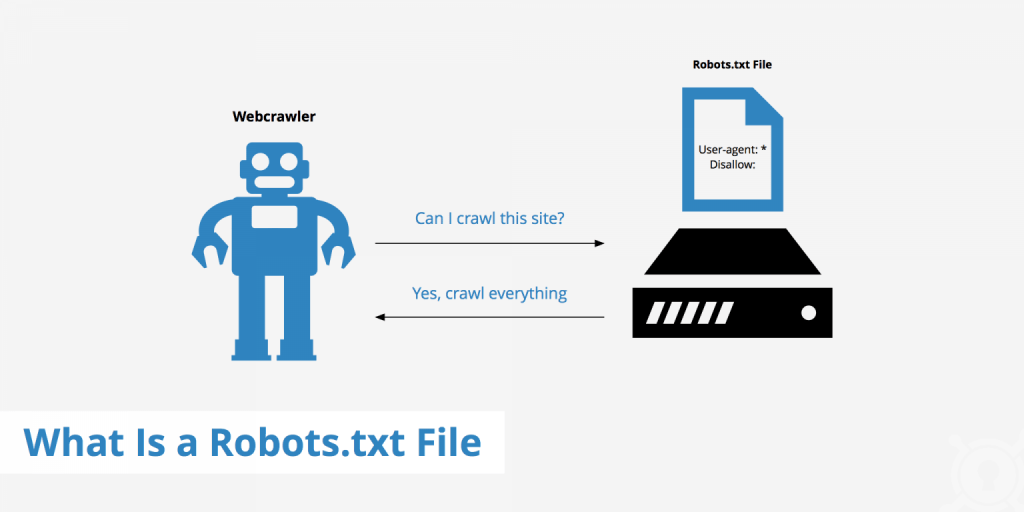

فایل robots.txt یا فایل ربات یکی از مهم ترین فایل های موجود در زمینه سئو هستش که بوسیله اون ارتباط وب سایت با موتورهای جستجو ممکن می شه و ما بوسیله فایل robots.txt به خزنده (Crawler)های موتورهای جستجو می گیم که کدام صفحات وب سایت ما رو ایندکس کنه در واقع ما بوسیله این فایل مشخص می کنیم که موتورهای جستجو به کدام صفحات وب سایتمون اجازه دسترسی دارند.

آیا برای وب سایت خود حتما باید فایل robots.txt را ایجاد کنیم ؟

فرقی نداره که شما فایل robots.txt رو ایجاد کنید یا خیر،به هر حال خزنده های موتورهای جستجو صفحات وب سایت شما رو ایندکس خواهند کرد.خب اگر یک همچین حالتی وجود داره پس چه لزومی به ساخت این فایل هستش ؟

واقعیت اینه که اگر شما وب سایت خودتون رو تازه تاسیس کرده باشید بدلیل اینکه صفحات زیادی نداره پس خزنده های موتورهای جستجو همه ی صفحات وب سایت شما رو ایندکس می کنن ولی زمانی که وب سایت شما رشد می کنه و تعداد صفحات وب سایت شما خیلی زیاد می شه دیگه این اتفاق نمی افته !.

اما چرا این اتفاق می افته ؟ بدلیل اینکه خزنده های موتورهای جستجو دارای یک سهمیه مشخص برای خزیدن و ایندکس کردن صفحات وب سایت ها هستند.خب پس با این تفاسیر متوجه می شیم که لازمه که ما فایل robots.txt رو برای وب سایت خودمون ایجاد کنیم و صفحات مورد نظرمون رو برای ایندکس شدن حتما مشخص کنیم.

چه صفحاتی رو بهتره که در فایل robots.txt قرار ندیم ؟

همونطور که متوجه شدید خزنده ها به طور محدود در هر سری صفحات وب سایت شما رو ایندکس می کنند و اگر در یک مرحله نتوانند صفحات وب سایت شما رو ایندکس کنند،بر می گردند و در سری بعدی این کار رو می کنند پس این یعنی اینکه یک سری صفحات شما دیرتر ایندکس می شوند و رتبه اون صفحات مورد نظر شما دیرتر بهبود پیدا می کنه ولی یک سری صفحات وب سایت شما اگر ایندکس نشوند هیچ اهمیتی ندارند صفحات و مسیرهای غیر ضروری مثل پلاگین ها ، تم ها و مدیریت وردپرس.پس شما با غیر فعال کردن ایندکس در این صفحات می تونید این مشکل رو رفع کنید.

چگونه یک فایل robots.txt بهینه بسازیم ؟

فایل robots.txt یک فایل متنی ساده هستش که در پوشه ی اصلی سایت ذخیره می شه و دارای چارچوب کلی بصورت زیر می باشد.

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]-

User-agent : بوسیله این قسمت مشخص می کنیم که دستوراتی که در این فایل می نویسیم برای کدام موتور جستجو هستش مثلا برای گوگل می توانیم بنویسیم Googlebot ولی معمولا علامت * را قرار می دیم که به معنای همه ی موتورهای جستجو هستش.

-

Disallow : دستورات جلوی این قسمت مشخص می کنه که ربات های خزنده موتورهای جستجو اجازه ورود به این پوشه و تمامی فایل های درون آنرا "ندارد".

-

Allow : دستورات جلوی این قسمت مشخص می کنه که ربات های خزنده موتورهای جستجو اجازه ورود به این پوشه و تمامی فایل های درون آنرا "دارند".

-

Sitemap : آدرس نقشه سایت خودتون رو می تونید در این قسمت قرار بدید که بدین وسیله موتورهای جستجو لیستی از تمامی لینک های مفید وب سایت شما رو در اختیار خواهند داشت.

نمونه ای از یک فایل robots.txt که بصورت بهینه ایجاد شده رو می تونید در زیر مشاهده کنید.

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml- تیر ۱۴, ۱۴۰۰

- ۷:۰۰ ب٫ظ

- آموزش وردپرس, سئو و بهینه سازی